sobota, 12 grudnia 2015

Rozpraszać czy pochłaniać?

Rozpraszanie nie rozwiązuje problemów z niskimi częstotliwościami. W niewielkich pomieszczeniach jedynym problemem jest odtwarzanie basu. Dyfuzor mogący skutecznie rozproszyć częstotliwości rzędu 50 czy 60 Hz miałby głębokość co najmniej 1/7 długości fali czyli około metra. Dlatego, że dyfuzory mają pomijalnie małe wymiary w odniesieniu do długości fal niskich częstotliwości, nie działają na basy. Poza tym, gdzie ma "się podziać" energia basu? Jeśli nawet, w jakiś paranormalny sposób, udałoby się rozbić falę niskiej częstotliwości, to ta rozproszona energia wciąż pozostanie w pomieszczeniu i będzie tam dokładnie tyle, aż nie zostanie przez coś pochłonięta i zamieniona w ciepło.

Nieporozumieniem jest mocowanie dyfuzorów na ścianie za głośnikami. Tam jest bas, a wyższych częstotliwości niż 400 Hz w sensie dźwięku bezpośredniego nie ma, gdyż głośniki promieniują je do przodu. Na tym polega paradoks, że dyfuzor nie ma wtedy na co działać. Sensowne byłoby, jeśli już ktoś chce mieć dyfuzory, umieszczenie ich na ścianie za plecami słuchacza. I to jest problem, gdyż jeśli ich nie widzimy w czasie słuchania, tracą swe walory dekoracyjne.

Skoro dyfuzory nie działają na niskie częstotliwości i ktoś wstawi je na ścianę za kolumnami, będą mogły rozpraszać wyższe częstotliwości, ale dopiero po odbiciu od ściany za plecami słuchacza. Dlatego ich zamocowanie za kolumnami nie ma sensu. Jeżeli dźwięk jest emitowany przez głośniki do przodu, odbije się on za plecami słuchacza i wróci do niego, czyli słuchacz usłyszy dźwięki odbite zupełnie jakby nie było żadnych ustrojów akustycznych i dopiero po minięciu słuchacza trafi na dyfuzor, ale to musztarda po obiedzie, bo odbicia już wpłynęły na brzmienie. Innymi słowy montowanie jak na rysunku poniżej ma tyle sensu, co otwarcie spadochronu, gdy skoczek uderzy w ziemię.

Energia dźwięku maleje wykładniczo wraz z odległością. Wobec tego do dyfuzora dotrze zaledwie ułamek energii wypromieniowanej przez głośnik. Jeżeli ktoś chce je mieć, ich miejscem powinna być tylna ściana, za plecami słuchacza. Jeżeli istnieje problem z basem, to nie tylko, że nie zostanie on zlikwidowany przez dodanie dyfuzorów, ale w związku z tym, że zmniejszy się kubatura pomieszczenia jeszcze wzrośnie. Pomieszczenie małe stanie się mniejsze i problemy z propagacją niskich częstotliwości będą bardziej dokuczliwe.

Dyfuzory są elementami aktywnymi w przeciwieństwie do absorberów. Stosując dyfuzory jesteśmy zmuszeni wykonać pomiary, gdyż dyfuzor staje się dodatkowym źródłem dźwięku. Jednak w praktyce pomiarów nie stosuje się. Co więcej nawet nikt się nie zastanawia nad tym jaki dyfuzor, jeśli w ogóle, byłby odpowiedni. Zakupy przeprowadza się na zasadzie kupna pasujących do wystroju. Z tego powodu, że instalacje audio wykonuje się często pod kątem wyglądu, a nie funkcjonalności, dlatego dyfuzory jako bardziej efektowne i "tajemnicze" cieszą się popularnością.

niedziela, 15 listopada 2015

Wszystkie wzmacniacze brzmią tak samo - uzupełnienie

Zakładam, że próbujemy porównać wzmacniacze tak rzetelnie, jak to tylko jest możliwe. Odrzucamy więc sztuczki sprzedawców w rodzaju - jeden wzmacniacz jest odsłuchiwany na piosence artysty A, a drugi na piosence artysty B. Albo piosenka jest ta sama, ale raz słuchamy oryginalnego wydania z roku 1984, a drugi raz wznowienia z masteringiem z roku 2004.

Problem z porównaniem wzmacniaczy jest taki, że tak naprawdę nie wiemy jak głośno słuchamy. Aby porównanie w ogóle miało sens musimy słuchać z jednakową głośnością. W poście "Testy i dlaczego w audio się nie testuje" starałem się wyjaśnić możliwie dokładnie dlaczego ustawienie jednakowej głośności jest tak ważne. Wobec tego wzięcie dwu wzmacniaczy, które są zupełnie identyczne, a nawet mają numer seryjny różniący się ostatnią cyfrą, jeśli nie ustawimy identycznej głośności skończy się tym, że jeden ze wzmacniaczy zostanie uznany za grający inaczej.

A teraz chciałbym pokazać w jaki sposób można uzyskać różne brzmienie z różnych wzmacniaczy, a nawet różne brzmienie z tego samego wzmacniacza.

|

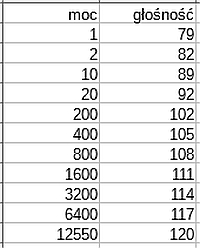

| Tabela pokazuje relację pomiędzy mocą wzmacniacza i osiąganym poziomem głośności. Przyjęto następujące założenia: dwie kolumny o skuteczności 82 dB/W i odległość dwa metry od kolumn. |

W tabeli są podane moce skutkujące określoną głośnością odsłuchu. Słuchanie zbyt głośno może spowodować, że krew zacznie płynąć z nosa, a mózg przez uszy.

Żeby osiągnąć dla podanych warunków głośność 120 dB potrzebujemy mocy 12550 watów. Tak duża moc wynika z tego, że w przykładzie są kolumny o małej skuteczności. To wartości teoretyczne i z praktyką nie mające nic wspólnego, ale pokazują, że do osiągnięcia dużych głośności są potrzebne spore moce.

100 dB osiągamy jeśli wzmacniacz gra z mocą 128 W na kanał. To znaczy, że jeśli do porównania weźmiemy kolumny o małej skuteczności, do osiągnięcia wcale nie aż tak dużych głośności potrzebować będziemy pokaźnych mocy. Jeżeli wybierzemy do porównania 2 wzmacniacze o mocach sinus 2x80W i 2x120W bez dwóch zdań ich brzmienie będzie bardzo różne, gdyż słabszy wzmacniacz będzie już bardzo przesterowany i zacznie mocno obcinać wierzchołki.

Mocniejszy wzmacniacz będzie generował np. 0,5% zniekształceń, a przesterowany 25%. Taką różnicę da się usłyszeć.

Jeśli do porównania weźmiemy kolumny o większej efektywności, to wcale nie znaczy, że wzmacniacze będą grały tak samo, bo oba będą poniżej clippingu. Wcale nie muszą być poniżej clippingu, bo przecież zawsze jest za cicho. Audiofilowi nigdy muzyka nie gra zbyt głośno. Na koncercie i w dyskotece ma 120 dB i więcej, więc i na odsłuchu chciałby tyle mieć. Nikt w jawnych odsłuchach nie używa oscyloskopu, żeby stwierdzić czy jest poniżej clippingu.

Dlatego, że tak łatwo jest przesterować wzmacniacz, bo zawsze jest za cicho, więc wzmacniacze brzmią różnie. Jeden jest przesterowany mniej, inny więcej. Ale przesterowane są wszystkie wzmacniacze i zawsze.

Więc jest całkiem możliwe, że jeśli ktoś miał fantazję popchnąć wzmacniacz 80W do 120W jednego dnia, a innego dnia ktoś inny dopchnął go do zaledwie 95W wrażenia z odsłuchów będą diametralnie różne. A przecież wzmacniacz był ten sam. I te same głośniki.

Na koniec zastanówmy się, co będzie, kiedy będziemy porównywać dwa wzmacniacze o różnej budowie, ale identycznej mocy. Identycznej powiedzmy - teoretycznie. Przesterowane w tym samym stopniu, bo grające z identyczną mocą, zagrają inaczej, gdyż inne będzie spektrum zniekształceń.

Fakt, że bez oscyloskopu nie da się testować udowodniono ponad wszelką wątpliwość. I stwierdzono również ponad wszelką wątpliwość, że różne wzmacniacze pracujące z identyczną mocą poniżej clippingu brzmią tak samo.

czwartek, 22 października 2015

Testy i dlaczego w audio się nie testuje

No jak to, przecież w audio się testuje! Testuje się, ale wyniki tych testów nigdy nie trafiają w ręce kupujących sprzęt. Producenci, ci poważni, testują ale zachowują wyniki dla siebie. Do Kowalskiego docierają zaś teksty sponsorowane i zakamuflowany marketing. Wydaje ci się, że masz masę testów, bo kupujesz magazyny audio? Niestety muszę cię rozczarować. To nie są testy, co prawda są tam często nawet jakieś dane pomiarowe, ale faktycznie jest to rodzaj zasłony dymnej, pozór rzetelności i profesjonalizmu.

Czy ktoś ma dane testowe zniekształceń wzmacniacza dla wszystkich poziomów mocy i całego zakresu częstotliwości? Ma ktoś dane jaki jest poziom zniekształceń dla 20 kHz i pełnego wysterowania? Albo 100 Hz i mocy 0,001W? A może wie jaki jest odstęp od szumów dla mocy 0,1W? Albo przy 10W? Niekoniecznie. Ale producenci, ci którzy testują, bo są i tacy którzy tego nie robią, mają. Tylko, że nie udostępniają. Nikomu.

A może ma ktoś dane dotyczące zachowania głośników przy 50 Hz takich jak zniekształcenia harmoniczne i intermodulacyjne? Dla różnych poziomów głośności? Albo chociaż wie jaka jest częstotliwość rezonansowa górna i dolna? A jak wygląda charakterystyka bez wygładzania i uśredniania?

Ktoś może podać z jaką częstotliwością pracuje DAC w jego odtwarzaczu? A jaka jest częstotliwość filtru dolnoprzepustowego, albo jak stromy czy odwrotnie, łagodny jest ten filtr?

Co my w ogóle wiemy o naszym sprzęcie? Nic nie wiemy. Niektórzy wierzą, że coś wiedzą, innym się wydaje, ale tak naprawdę nie wiemy nic. Jeśli ktoś jest uparty, może zdobyć schematy i po kolei sprawdzać specyfikacje poszczególnych elementów. Ale jak to działa jako całość i jakie są testowe dane pomiarowe tego się nie dowie o ile sam nie zmierzy. Tylko czy samemu można coś zmierzyć?

Oczywiście, że można. Trzeba wiedzieć co i jak mierzyć i mieć czym. Sprzęt pomiarowy jest drogi, zmierzenie wszystkiego wymaga sporych zakupów i może się okazać, że mamy zestaw audio za "ileś tam" pieniędzy, natomiast sprzęt pomiarowy do przetestowania tego zestawu będzie kosztował "ileś" razy 10.000 lub jeszcze więcej.

Więc jakie mamy dane o naszym sprzęcie, który gra nam na co dzień? Takie, jak się zdecydował pokazać dział marketingu. Czy mają one jakieś odniesienie do faktycznych pomiarów? Oczywiście, że mają. Ale co z tego, skoro nie wiadomo jak pomiary zostały wykonane i nawet nie wiadomo dokładnie co mierzono. Podano ci moc, ale dla jakich zniekształceń? Podano ci pasmo, ale dla jakiej tolerancji? Podano ci odstęp od szumu, ale przy jakiej mocy?

Osobną ligę tworzą testy odsłuchowe. To one wzbudzają największe emocje i dyskusje. I to właśnie ich się w audio nie robi. Producenci, niektórzy, wykonują testy odsłuchowe, ale oczywiście nie znamy ich rezultatów. Przypuszczalnie łatwiej będzie się komuś dowiedzieć co jest w strefie 51 niż poznać wyniki testów jakichś urządzeń audio.

W magazynach audio w każdym razie nie wykonuje się testów odsłuchowych i jest tylko jeden powód. Są one całkowicie nieprzydatne marketingowo. Zamiast testów dostajemy coś w rodzaju radosnej twórczości niespełnionych literacko bajkopisarzy. Opisują swoje wyobrażenia o brzmieniu ze słuchania jakichś nagrań, jeśli w ogóle czegoś słuchają i w ogóle widzą sprzęt o którym piszą. Chociaż nie, tak było kilkadziesiąt lat temu Teraz istnieje już pewien schemat co powinna zawierać "recenzja" sprzętu. Jakich frazesów należy użyć, jakie słowa-klucze muszą się znaleźć, jednym słowem literatura-makulatura musi sprostać oczekiwaniom kupujących. Musi trafiać w ich potrzeby i odpowiadać aktualnie obowiązującej modzie.

A jakie są potrzeby kupujących? Chcą się czuć kimś wyjątkowym, kto się świetnie zna - bo opanował nowomowę - i mieć poczucie posiadania jakiegoś super wypasionego i posiadającego niesamowite właściwości sprzętu, który uczyni ich jeszcze bardziej cool i trendy. Tylko czy można zaimponować komukolwiek, zwłaszcza samemu sobie, jeśli sprzęt ten wyszukany, wymarzony, wyśniony i strasznie drogi nie daje nic poza tym, co zwykły telefon, przenośny odtwarzacz plików i słuchawki? A czy będziemy podziwiać kogoś, kto wydał masę pieniędzy na wzmacniacz i kolumny, skoro taki sam efekt - na ucho, nie na oko - gwarantuje sprzęt za ułamek tej sumy? Za jedną setną? Albo nawet jeszcze mniej, są przecież zestawy za milion dolarów i więcej.

Magazyny branżowe nie testują, bo sponsorzy nie za to im płacą. Producenci owszem testują, ale nie udostępniają wyników. Czy wobec tego można testować samemu?

Nie damy rady przetestować żadnego urządzenie w sensie pomierzenia jego parametrów. Tak samo nie uda się sprawdzić osiągów własnego auta. Do takich celów potrzebny jest sprzęt, a ten sporo kosztuje. Poza tym wymagane jest doświadczenie i jeszcze kilka innych rzeczy.

A co z testami odsłuchowymi? Czy może być coś trudnego w tym, żeby posłuchać i wydać werdykt? Jest coś trudnego. Jest wiele trudnych rzeczy. Kilka z nich jest tak trudnych, że praktycznie niewykonalnych.

Co to w ogóle jest test odsłuchowy? Można podać kilka typów testów w zależności od tego, do czego mają służyć. Zazwyczaj myśli się o takim teście, który odpowie na pytanie jak dobra jest jakość, inny test odpowiada na pytanie co jest lepsze. Są też testy mające wykazać różnice. Żadnego z tych typów testu nie uda się nam wykonać w warunkach domowych. Zresztą jakikolwiek test byśmy zamierzali przeprowadzić w warunkach domowych w którym do oceny będzie służyć słuch, musi się on skończyć niepowodzeniem.

Gwarantem niepowodzenia, nawet jeśli wszystko inne by poszło dobrze, a dobrze pójść nie ma prawa, jest fakt, że z całą pewnością nie spodobają nam się wyniki testu i zaraz po jego zakończeniu zaczniemy planować inny. Taki który da lepsze wyniki czyli te, które chcemy otrzymać.

Amatorski test odsłuchowy nie może się udać również z tego powodu, że sędzia nie może sądzić we własnej sprawie. Obejść tą zasadę można w ten sposób, że sędziego sądzi jego kumpel konkretnie ten, na którego podsądny ma haka. Jeżeli oceniasz swój sprzęt nie będziesz obiektywny. Poza tym oceniając swój sprzęt mamy chęć "podglądać". Kumple, którzy biorą udział w teście też nie będą pomocni. Twój sprzęt ma być lepszy niż mój?

Testowanie ma sens tylko wtedy, kiedy są spełnione pewne przesłanki, a najważniejszą z nich jest taka, że ani ten co testuje, ani ten co prowadzi test nie wiedzą co testują. Wynika z tego, że do wykonania testu trzeba mieć zewnętrzną, niezależna instytucję, a to wyklucza test we własnym zakresie.

Kolejną przeszkodą o którą się rozbijają amatorskie testy jest statystyka. Statystyka i rachunek prawdopodobieństwa nie są bardzo trudne, ale wymagają pewnej wiedzy. Żeby wykazać, że coś rzeczywiście gra inaczej i się coś słyszy, a nie zgaduje, trzeba odpowiedzieć poprawnie wymaganą ilość razy w wymaganej ilości prób. Amatorzy, którzy czasem coś "testują" nie uznają statystyki, albo jej nie uwzględniają. Wobec tego wykonują 3 próby z czego 2 razy udało się odpowiedzieć dobrze. Czy to znaczy, że się coś usłyszało? To nic nie znaczy. Można wziąć monetę i odpowiadać tak, jak ona upadnie i mieć "świetne" rezultaty, przykładowo właśnie 2 dobre na 3 próby. Żeby wykazać, że się naprawdę słyszy, musimy wykonać znacznie więcej prób niż 3. Co najmniej 10. A poprawnie odpowiedzieć co najmniej 9 razy. 2 na 3 można odgadnąć rzucając monetą. 9 na 10 już trzeba naprawdę wiedzieć. Jeśli prób będzie 20 to musisz odpowiedzieć dobrze 15 razy.

Nawet gdyby komuś udało się przebrnąć przez te wszystkie przeszkody, pozostaje jeszcze kilka innych. Największym problemem pozostają jednak właściwości słuchu. Chodzi o to, że słuch nie ma właściwości liniowych. Żeby to zrozumieć musimy koniecznie zrozumieć poniższy wykres.

poniedziałek, 12 października 2015

50 lat systematycznej pracy marketingu i mamy w audio rynek zjawisk paranormalnych

Pierwsze sygnały wskazujące na degenerację przemysłu hi-fi zaczęły się pojawiać pod koniec lat siedemdziesiątych. Już wtedy padały pytania czy faktycznie jest sens jeszcze bardziej śrubować parametry wzmacniaczy, skoro zniekształcenia są tak małe, że i tak ich nikt nie słyszy.

Pod koniec lat siedemdziesiątych nie było jeszcze płyt kompaktowych. Muzyki słuchaliśmy z płyt analogowych i magnetofonów. Ci zamożniejsi mogli sobie kupić oryginalne płyty, a ci mniej zamożni zadowalali się kopiami tych płyt wykonanymi na taśmach. A proletariat - czyli również ja - słuchał płyt granych przez radio. Najczęściej jednak słuchaliśmy taśm, na których były nagrania płyt puszczanych przez radio. Oczywiście radio odtwarzało płyty wcześniej skopiowane na taśmę często z innej taśmy.

Irracjonalność śrubowania parametrów wzmacniaczy schodziła na drugi plan. Przecież było jeszcze wiele do zrobienia jeśli chodzi o jakość dźwięku. Kto miał płyty chciał mieć lepszy gramofon, lepszą wkładkę, lepszą igłę. Kto słuchał płyt z taśmy starał się zdobyć lepszy magnetofon. Najczęściej te dążenia do lepszego dźwięku ograniczały się do zdobycia lepszej taśmy. Jak ktoś miał taśmy BASF to był gość! A ten co nagrywał z radia chciał mieć lepsze radio, magnetofon, taśmę, wszystko. Mało kto chciał mieć lepszą antenę, zastanawiające.

W latach siedemdziesiątych droga do dobrej jakości dźwięku była długa i wyboista. I zawsze wiodła pod górę. Nawet wybrańcy, którzy mieli płyty nie mogli być w pełni usatysfakcjonowani. Bo przecież mało kto miał nowe płyty. Poza tym nawet nowa płyta po niedługim czasie staje się starym, porysowanym, brudnym, trzeszczącym, chrypiącym i zdartym dziadostwem, którego się nie da się słuchać.

Jedno jest jednak równie pewne jak to, że politycy reprezentują interesy wyborców tylko do dnia wyborów. Analogowe źródła dźwięku były różne. Różniły się od siebie jak dzień i noc. Brzmienie oryginalnej płyty odtwarzane na porządnym gramofonie było czymś zgoła innym od nagrania z radia na taśmie.

Nie można nie wspomnieć tunerów radiowych. Tunerów i radioodbiorników. W ogóle tunery to świetny pretekst do rozwinięcia wątku dotyczącego analogowych źródeł dźwięku. Płyta - wiadomo. Taśma - też. Ale przecież radio jest analogowym źródłem dźwięku. Radio UKF FM jest wciąż powszechnym źródłem analogowego dźwięku. A z tą radiową jakością bywało różnie. I jest różnie.

Okazuje się mianowicie, że sporo zależy od nadajnika. I od Orbana. I jeszcze wielu innych rzeczy. Ale przecież sporo zależy też od jakości nośnika, z którego się w radio gra. W tamtych latach grało się najczęściej z taśm. Ktoś kopiował płyty na taśmę, a potem często jeszcze ktoś inny kopiował tą kopię na inną taśmę, z której grało się na antenie. Więc odtwarzało się kopię kopii płyty, a bywało też, że to była kopia kopii kopii. Kiedy w radio zaczęto grać "prosto z płyty" pojawiła się nowa jakość nadawania. Następnym skokiem jakości było odtwarzanie kompaktów.

Słuchając nagrań starych archiwalnych audycji, które wykonali słuchacze, możemy przeanalizować ich jakość. Oczywiście jest słaba. W tych nagraniach słychać zniekształcenia wniesione przez taśmę, magnetofon, tuner - szczególnie często słychać szum towarzyszący odbiorowi stereo. Ale jednak pamiętamy wszyscy, że jakość dźwięku słuchanego na żywo była często znakomita. Zależy kto na czym słuchał, ale jak miał na czym, jakość była naprawdę doskonała. Kto pamięta pierwszą emisję "Brothers in Arms" wie o co chodzi.

W tamtych czasach nikt nie zwracał uwagi na absurdalność śrubowania parametrów wzmacniaczy, bo jakość w ogóle pozostawiała sporo do życzenia. Płyty analogowe miały, i wciąż mają, swe wady. Magnetofony, zwłaszcza kasetowe - również. Radio nie zawsze ładnie grało. Kto by się tam wzmacniaczem przejmował? Zwłaszcza tym, że jest tak dobry, że lepszy być nie może!

No a ilu z nas miało porządne kolumny? Normą były Altusy, a jak nie Altusy, to i tak były to kolumny z marnymi głośnikami z membranami zrobionymi z makulatury, w kiepskich skrzynkach i z prostymi zwrotnicami 6 dB/okt.

Ale czasy się zmieniają. W latach dziewięćdziesiątych problem jakości źródła dźwięku staje się już nieaktualny. Kto chce mieć jakość, ten kupuje odtwarzacz płyt kompaktowych i kompakty. Niemniej jednak już w latach osiemdziesiątych temat jakości elektroniki wraz z pojawieniem się odtwarzaczy CD Audio został zamknięty. Pod kątem jakości nie można było zrobić już nic więcej. Oczywiście są ludzie, którzy upierają się, że ekspres do kawy nalewający z dokładnością do tysięcznej części mililitra jest dla smakosza sprawą pierwszorzędną, ale ktoś, kto jest kawoszem a nie mitomanem ma na ten temat inne zdanie. Co innego kolumny.

Już nie raz i nie dwa pisałem, niekoniecznie na blogu, że elektronika stoi na poziomie techniki kosmicznej podczas gdy głośniki są w erze kamienia łupanego. Ale może dajmy tym razem spokój głośnikom. Wypada wspomnieć, że od czasu, kiedy poważnie zaprzęgnięto do pracy nad głośnikami, zwrotnicami i w ogóle nad kolumnami komputery, także na tym polu osiągnięto już wszystko, co jest możliwe. Dopóki pozostaniemy przy stosowaniu tradycyjnych głośników, kolejne generacje będą się różnić raczej wyglądem niż jakością. Grać mogą oczywiście różnie, ale to nie będzie wynikać z jakości tylko będzie zależało od decyzji, że własnie tak mają grać. Wybór materiału ma przetworniki i planowanie barwy w sensie przebiegu charakterystyki częstotliwościowej - tylko tyle pozostało konstruktorom. Resztę wyliczy komputer. A wszystko inne to ideologia i dyskusja nad wyższością świąt Bożego Narodzenia nad Wielkanocą.

Paradoksalnie wszyscy przywiązują do kolumn najmniejsze znaczenie. Kolumna? Brzmienie?

Iii tam, kolumna. Wzmacniacz. Kabel. To się dla Kowalskiego liczy. Ta... kabel. Kabel byłby ważny w dzieciństwie, coby nim dać niedojrzałym audiofilom po dupie. Teraz na kable jest już za późno.

Co by się stało z producentami sprzętu audio, gdyby ktoś pod koniec lat osiemdziesiątych powiedział: "W porządku riebiata, odtwarzacze mamy obcykane do perfekcji, to samo ze wzmacniaczami. Może coś się jeszcze da zrobić z kolumnami, ale niewiele i to by było wszystko na temat"? No ale przecież ubrać się można i za tysiąc złotych i za milion.

Jeśli chodzi o garderobę i powiedzmy buty, to przynajmniej nikt nie przekonuje, że w butach za stówę nie można wejść na swoją jedynie słuszną i właściwą ścieżkę prowadzącą do odkrycia prawdy absolutnej.

Pytanie, które mnie nurtuje nie polega na tym, kto i kiedy zaczął pisać te wszystkie banialuki o grających w ciepło/zimno wzmacniaczach i o odtwarzaczach oświetlających/przyciemniających brzmienie. Czy jakieś inne bzdury. Zastanawiające jest to, dlaczego przez niemal pół wieku nikt tego nie ośmieszył ostatecznie i raz na zawsze?

Bo trudno jest uwierzyć, że producenci sprzętu audio mają totalną kontrolę nad tym, co się pisze i mówi. Bardziej prawdopodobne jest, że ludzie po prostu wzięli te wszystkie marketingowe dyrdymały za prawdę i naprawdę nikt nie śmiał nawet mieć cienia wątpliwości co do prawdziwości tego reklamowego bełkotu.

sobota, 10 października 2015

Rozpowszechnianie muzyki w formacie 24 bity 192 kHz nie ma sensu

Zobacz również Xiph.Org's video, Digital Show & Tell gdzie jest pokazane jak faktycznie wygląda sampling wykonany na rzeczywistym sprzęcie.

W ubiegłym miesiącu ukazał się artykuł w którym muzyk Neil Young oraz szef Apple'a Steve Jobs dyskutują o ofercie rozpowszechniania plików muzycznych w "bezkompromisowej jakości studyjnej". Większość prasy i użytkowników niemal entuzjastycznie komentowała perspektywę pobierania nieskompresowanych plików 24 bity 192 kHz. Muzyka w formacie 24 bity 192kHz była tematem moich rozmów z grupą Pana Younga kilka miesięcy temu.

Niestety, dystrybucja muzyki w formacie 24-bit/192kHz nie ma sensu. Jakość odtwarzania tych plików jest nieco gorsza niż 16/44.1 lub 16/48, a poza tym są one nawet 6 razy większe.

Jest kilka rzeczywistych problemów z jakością audio i odtwarzaniem cyfrowo dystrybuowanej muzyki w dzisiejszych czasach. 24/192 nie rozwiązuje żadnego z nich. Choć wszyscy widzą w 24/192 panaceum, to jednak nie przynoszą one żadnej faktycznej poprawy.

Najpierw złe wieści

W czasie kilku minionych tygodni miałem okazję rozmawiać z ludźmi inteligentnymi, którzy myślą w kategoriach ścisłych wierzącymi w pobrania 24/192 i zdziwionymi dlaczego ktoś mógłby się z nimi nie zgadzać. Zadawali oni ciekawe pytania, które wymagają szczegółowych odpowiedzi.

Chciałem też wiedzieć co motywuje zwolenników audio o wysokim samplingu. Odpowiedzi tych osób wskazywały, że niewielu z nich rozumie podstawy teorii sygnału lub teorię samplingu , co zresztą nie zaskakuje. Niezrozumienie matematyki, technologii, a także fizjologii były widoczne w rozmowach, co zresztą zdarza się też profesjonalistom mającym skądinąd sporą wiedzę o audio. Niektórzy nawet argumentowali, że teoria samplingu faktycznie nie wyjaśnia jak naprawdę działa cyfrowe audio[1].

Dezinformacja i przesądy służą wyłącznie szarlatanom. Więc przedstawmy pewne podstawy dlaczego dystrybucje 24/192 nie mają sensu, zanim będziemy sugerować rozwiązania, które naprawdę działają.

Proszę Państwa, oto wasze uszy

Ucho słyszy za pośrednictwem komórek słuchowych, które znajdują się na podstawnej błonie rezonansowej w ślimaku. Każda komórka ma włoski efektywnie dostrojone do wąskiego pasma częstotliwości określonego przez ich pozycję na membranie. Szczyty czułości są w środku pasma i spadają na strony w krzywych stożka pokrywających się z innymi pasmami pobliskich komórek słuchowych. Dźwięk nie jest słyszalny, jeśli nie ma komórek słuchowych dostrojonych na to pasmo.

Powyżej po lewej: przekrój ślimaka człowieka wraz z membraną basilarną (kolor beżowy). Membrana jest nastrojona aby rezonować na różnych częstotliwościach wzdłuż ślimaka, przy czym wyższe częstotliwości są przy podstawie a niższe przy wyrostku. Zaznaczono przybliżoną lokalizację dla wybranych częstotliwości.

Powyżej po prawej: Schematyczny diagram przedstawiający odpowiedzi komórek słuchowych wzdłuż błony podstawnej w postaci szeregu filtrów nakładających się na siebie.

To jest podobne do analogowego radia odbierającego silne częstotliwości w pobliżu tej na którą jest nastrojone. Im dalej jest częstotliwość radiowa tym jest słabiej odbierana i z większymi zniekształceniami, aż zaniknie zupełnie, bez względu na to jak jest silna. Istnieje górna i dolna granica słyszenia, którą wyznacza czułość ostatnich włosków słuchowych spadająca do zera, gdzie słyszenie się kończy.

Częstotliwość próbkowania i zakres słyszenia

Jestem pewien, że słyszeliście to wiele razy, że zakres słyszenia rozciąga się od 20 Hz do 20kHz. Ważne, żeby wiedzieć jak badacze doszli do tych liczb.

Po pierwsze, musimy zmierzyć "absolutny próg słuchu" w całym zakresie audio. To daje nam krzywą słyszenia najcichszych dźwięków przez ucho człowieka dla danej częstotliwości mierzonej w idealnych warunkach dla zdrowych uszu. Komora bezechowa, sprzęt odtwarzający, precyzyjne kalibrowanie i rygorystyczna analiza statystyczna są łatwiejszą częścią przedsięwzięcia. Słuch się męczy, a koncentracja spada, więc badania trzeba przeprowadzić, kiedy słuchacz jest wypoczęty. Oznacza to wiele przerw i pauz. Badanie trwa od wielu godzin do wielu dni, w zależności od metody.

Później zbiera się dane dla przeciwnego bieguna - granicy bólu. To punkt, gdzie amplituda dźwięku jest tak duża, że ucho jako narząd i jego unerwienie jest tak kompletnie przeciążone, że pojawia się fizyczny ból. Zbieranie danych jest skomplikowane. Nikt nie chce permanentnie uszkodzić komuś słuchu w czasie badań.

Powyżej: Przybliżone krzywe równych głośności opracowane przez Fletchear i Munsona (1933) plus częstotliwości ponad 16kHz. Bezwzględny próg słuchu i progu bólu są zaznaczone na krzywej na czerwono. Inni naukowcy doskonalili te odczyty zsumowane w skalę Phon i ISO 226 - standardowe krzywe równej głośności. Nowoczesne dane wskazują, że ucho jest znacznie mniej wrażliwe na niskie częstotliwości niż wykazali Fletcher i Munson.

Górną granicę zakresu słyszenia człowieka określa się, gdy bezwzględna wartość progowa krzywej słuchu przekracza próg bólu. Żeby mieć choć blade pojęcie o tym punkcie (lub poza nim), to trzeba słuchać nieznośnie głośno.

Przy niskich częstotliwościach, ślimak działa jak obudowa bass reflex. Helicotrema to otwór na wierzchołku błony podstawnej, która działa jako łącze dostrojone na częstotliwości pomiędzy 40Hz 65Hz w zależności od osoby. Odpowiedź zjeżdża stromo poniżej tej częstotliwości.

Tak więc 20Hz - 20kHz to jest szeroki zakres. Dokładnie pokrywa słyszalne spektrum i teza ta poparta jest prawie wiekiem prac doświadczalnych.

Genetyczny dar i złote uszy

Z mojej korespondencji wynika, że wielu ludzi wierzy w osoby z niezwykłym darem słuchu. Czy naprawdę istnieją takie "złote uszy"?

To zależy od tego, co nazywasz złotym uchem.

Młode, zdrowe uszy słyszą lepiej niż stare lub chore. Niektórzy ludzie są wyjątkowo dobrze wyszkoleni, aby usłyszeć dźwięk i niuanse w muzyce o których większość ludzi nawet nie wie, że istnieją. Był czas, w 1990 roku, kiedy mogłem zidentyfikować wszystkie typy dźwięku enkodera mp3 (ale to było wtedy, gdy wszystkie były bardzo złe) i potwierdzić to w podwójnie ślepym teście[2].

Kiedy zdrowy słuch połączy się z wyszkoloną umiejętnością wyłapywania różnic, nazwałbym je złotym uchem. Mimo to ludzie ze słuchem poniżej średniej po przeszkoleniu są w stanie wyłapać szczegóły niezauważane przez nieprzeszkolonych. Złote uszy to wynik treningu, a nie możliwości słyszenia ponad normalne możliwości.

Naukowcy chcieliby znaleźć, przebadać i udokumentować osoby o nieprzeciętnym zakresie słyszenia lub innych nadzwyczajnych cechach. Zwyczajni ludzie są fajni, ale każdy chciałby znaleźć kogoś wyjątkowego, żeby to ciekawie się prezentowało w publikacjach. Jednak jak dotąd przez ostatnie 100 lat nikogo takiego nie znaleziono. Ale wciąż się szuka.

Spectrofilia

Być może jesteś sceptyczny wobec wszystkiego, co tu napisałem; bo to z pewnością nie zgadza się z materiałami marketingowymi. Jednak zastanówmy się nad hipotetycznym zbzikowanym spektrum wideo, które nie będzie obarczone audiofilskim bagażem.

Powyżej: Przybliżona skala logarytmiczna reakcji słupków i pręcików w nałożonych na widmo widzialne. Te narządy zmysłów reagują na światło w nakładających się na siebie wycinkach spektralnych, podobnie jak komórki słuchowe ucha są dostrojone do reagowania na nakładające się pasma częstotliwości dźwięku.

Ludzkie oko widzi ograniczony zakres częstotliwości światła, to znaczy widmo widzialne. Jest to analogiczne do słyszalnego spektrum fal dźwiękowych. Podobnie jak ucho, oko ma komórki czuciowe (czopki i pręciki), które wykrywają światło w różnych nakładających się pasmach częstotliwości.

Widoczne spektrum rozciąga się od około 400 THz (czerwień) do głębokiego fioletu (850 THz). Percepcja spada gwałtownie na brzegach. Poza tym zakresem natężenie światła potrzebne do najmniejszej percepcji może uszkodzić siatkówkę oka. Zakres światła widzialnego jest bardzo szeroki nawet dla ludzi młodych, zdrowych, bez wad genetycznych i ma podobne limity co spektrum słyszalne.

W naszym hipotetycznym przykładzie zbzikowanego spektrum wideo mamy grupę spektrofilów, którzy wierzą, że ten widzialny zakres światła jest niewystarczający. Proponują więc oni, że wideo nie może obejmować tylko widmo widzialne, ale powinno zawierać również światło podczerwone i ultrafioletowe. Kontynuując porównanie robi się jeszcze większy Hardcore (i spektrofile są z tego dumni!) Jest frakcja, która podkreśla, że ten rozszerzony zakres wciąż jeszcze jest niewystarczający i że jest mocno przekonana, że wideo będzie bardziej naturalne, gdy obejmie ono także zakres promieniowania kuchenki mikrofalowej i część widma rentgenowskiego. Dla Złotych Oczu, to będzie różnica jak dzień i noc!

Oczywiście jest to niedorzeczne.

Nikt nie może zobaczyć promieni X (lub podczerwieni lub ultrafioletu lub mikrofal). Nie ma znaczenia ile osób wierzy, że może. Siatkówka po prostu nie jest do tego zdolna.

Każdy może zrobić taki eksperyment: weź po pilota do telewizora z LEDami z emisją w podczerwieni 980 nm (lub 306THz) w widmie w bliskiej podczerwieni. Nie jest to daleko poza widzialnym zakresem. Weź pilota do piwnicy lub najciemniejszego pokoju w domu w środku nocy, z wyłączonymi światłami. Niech twoje oczy przyzwyczają się do ciemności.

Powyżej: Pilot IR sfotografowany aparatem cyfrowym. Choć emiter jest dość jasny i częstotliwości emitowane są bliskie czerwonej części widma widzialnego, jest całkowicie niewidoczny dla oka.

Czy potrafisz zobaczyć świecenie diody jak naciskasz przyciski[4]? Nie? Wcale nie? Sprawdź to z innymi pilotami; wiele z nich działa na paśmie bliskim widzialnemu, około 310-350THz. Tego też nie będziesz w stanie zobaczyć. Reszta działa na krawędzi światła widzialnego około 350-380 THz i można z trudem coś zobaczyć, gdy oczy przystosują się do ciemności[5]. Każdy z tych pilotów świeciłby oślepiająco jasno, gdyby działał w paśmie widzialnym.

Te diody bliskiej podczerwieni emitują widzialne światło co najwyżej 20% poza granicą widzialnych częstotliwości. Audio 192 kHz rozciąga się 400% poza zakresem dźwięków słyszalnych. Mogę być oskarżony o porównywanie jabłek i pomarańczy, ale percepcja wzrokowa i słuchowa maleje w kierunku krańców zakresu.

192 kHz jest szkodliwe

Pliki z muzyką 192 kHz nie oferują żadnych korzyści. One nie są nawet neutralne, w praktyce jakość jest nieco gorsza. Ultradźwięki są problemem w czasie odtwarzania.

Ani przetworniki audio, ani wzmacniacze nie są wolne od zniekształceń, a zniekształcenia mają tendencję do wzrastania przy najmniejszych i największych częstotliwościach. Jeśli przetwornik reprodukuje jednocześnie z zawartością słyszalną również ultradźwięki, to jego nieliniowość spowoduje, że zniekształcenia intermodulacyjne zostaną przesunięte w dół i pokryją cały zakres częstotliwości słyszalnych. Nieliniowość wzmacniacza da taki sam efekt. Skutek jest bardzo niewielki, ale testy potwierdziły, że oba efekty mogą być słyszalne.

Powyżej: Ilustracja zniekształceń wynikających z intermodulacji częstotliwości 30kHz i 33 kHz dla teoretycznego wzmacniacza o niezmiennym poziomie zniekształceń harmonicznych (THD) około 0,09%. Zniekształcenia pojawiają się w całym spektrum, w tym na częstotliwościach niższych od obu częstotliwości.

Niesłyszalne ultradźwięki przyczyniają się do powstania zniekształceń intermodulacyjnych w zakresie słyszalnym (obszar jasnoniebieski). Systemy nieprzeznaczone do reprodukcji ultradźwięków zazwyczaj mają znacznie wyższy poziom zniekształceń powyżej 20kHz, powodując większe intermodulacje. Poszerzenie pasma częstotliwości o zakres ultradźwięków wymaga kompromisów, które zwiększają szum i zakłócenia w spektrum dźwiękowym. Tak czy inaczej, reprodukcja treści zbędnych pogarsza jakość.

Jest kilka sposobów, aby uniknąć tych dodatkowych zniekształceń:

1) Dedykowane wyłącznie do ultradźwięków głośniki, wzmacniacze i zwrotnice aby odizolować i przetwarzać ultradźwięki niezależnie, których i tak nie możesz słyszeć, wyłącznie po to, żeby nie zakłócały dźwięków słyszalnych.

2) Wzmacniacze i przetworniki zaprojektowane do przetwarzania szerszego pasma, aby aby ultradźwięki nie powodowały słyszalnych intermodulacji. Dając taką samą złożoność i nakład, ten dodatkowy zakres częstotliwości musi się odbić na obniżeniu reprodukcji w zakresie słyszalnym.

3) Głośniki i wzmacniacze zaprojektowane starannie, żeby nie przenosiły w ogóle ultradźwięków.

4) Brak kodowania tak szerokiego zakresu częstotliwości już na początku. Nie będziesz mieć i nie możesz mieć zniekształceń intermodulacyjnych w paśmie słyszalnym, jeśli brak zawartości ultradźwiękowej.

We wszystkim chodzi o to samo, ale tylko 4) ma sens.

Jeśli jesteś zainteresowany jak twój system działa, to są próbki zawierające częstotliwości 30 kHz i 33 kHz w plikach WAV 24/96, i dłuższe wersje we FLAC, kilka modulacji trzech częstotliwości, zwykła piosenka całkowicie przesunięta poza 24 kHz tak, że jest tylko w zakresie 24kHz - 46kHz:

Testy intermodulacji:

[Tu znajdowały się oryginalnie linki do plików. Łącza przestały działać]

Zakładając, że twój system jest faktycznie zdolny do odtwarzania 96 kHz [6], to powyższe pliki powinny być zupełną ciszą bez słyszalnych szumów, tonów, trzasków lub innych dźwięków. Jeśli coś słyszysz, to twój system ma nieliniowość powodującą słyszalne intermodulacje z ultradźwięków. Bądź ostrożny ze zwiększaniem głośności; jeśli wejdziesz w cyfrowy lub analogowy clipping, nawet delikatny, to spowoduje głośne tony intermodulacyjne.

Podsumowując, nie jest pewne czy intermodulacje z ultradźwięków będą słyszalne na danym systemie. Dodane zniekształcenia mogą być bez znaczenia albo mogą być zauważalne. Tak czy inaczej ultradźwięki nigdy nie są korzyścią i na wielu systemach będą wyraźnie obniżać jakość. W systemach gdzie to nie szkodzi, koszty i komplikacje mogą być zaoszczędzone lub przeznaczone na poprawę jakości zakresu słyszalnego.

Błędy i nieporozumienia w kwestii samplingu

Próbkowanie jest niezrozumiałe bez zagłębienia się w teorię przetwarzania sygnału. Nic dziwnego, że większość ludzi, nawet genialnych doktorantów w innych dziedzinach, rutynowo tego nie rozumieją. Nie jest również zaskakujące, że wiele osób nie zdaje sobie sprawy, że pojmują to źle.

Powyżej: Sygnały samplowane są często przedstawiane jako kanciaste schodki (czerwony), które wydają się słabym przybliżeniem oryginalnego sygnału. Jednak matematyczna reprezentacja jest precyzyjna i dokładna, sygnał odzyskuje gładki kształt oryginału (niebieski) po przetworzeniu z powrotem na sygnał analogowy.

Najczęstszym nieporozumieniem jest to, że uważa się sampling za niedokładny i stratny. Sygnał próbkowany jest często przedstawiany jako postrzępiony, schodkowy, kanciasty widok oryginalnego idealnie gładkiego przebiegu. Jeśli w ten sposób wyobrażacie sobie jak działa sampling, to możecie wierzyć, że im gęstszy (większa częstotliwość) będzie sampling (oraz im więcej bitów na próbkę), to te schodki będą coraz mniejsze i przybliżenie będzie lepsze. Sygnał cyfrowy będzie brzmiał najbliżej oryginału, jeśli częstotliwość próbkowania zbliży się do nieskończoności.

Podobnie, wiele osób nieznających się na cyfrowym przetwarzaniu dźwięku patrząc na coś takiego:

powiedzą: Ach! Wygląda na to, że samplowany sygnał reprezentuje wyższe częstotliwości źle. Lub też, że im wyższa częstotliwość sygnału, tym niższa jakość a przebieg częstotliwości opada, albo że staje się wrażliwy na fazę sygnału wejściowego.

Pozory mylą. Te wszystkie przekonania są błędne!

Wszystkie sygnały leżące całkowicie poniżej częstotliwości Nyquista (połowa częstotliwości próbkowania) są samplowane idealnie i w sposób dokładny; nieskończona częstotliwość próbkowania nie jest wymagana. Próbkowanie nie wpływa na spadek poziomu dla większych częstotliwości lub fazę. Sygnał analogowy można zrekonstruować bezstratnie, dokładnie i z odwzorowaniem wejściowej fazy oryginalnego sygnału analogowego.

Tak więc model matematyczny jest idealny, ale co z komplikacjami realnego świata? Najtrudniejszy jest wymóg ograniczenia pasma. Zawartość sygnału powyżej częstotliwości Nyquista musi zostać odfiltrowana, aby uniknąć zniekształceń aliasingu; to właśnie ten analogowy filtr dolnoprzepustowy jest niesławnym filtrem antyaliasingowym. Antyaliasing nie może być idealny, ale nowoczesne technologie zbliżają się do doskonałości... i w ten sposób dochodzimy do oversamplingu.

Oversampling

Próbkowanie szybsze niż 48 kHz jest bez znaczenia w odniesieniu do jakości dźwięki, ale jest niezbędne dla kilku nowoczesnych technik cyfrowych. Najlepszym przykładem jest oversampling[7].

Oversampling jest prosty i potrzebny. Można przypomnieć z mojego filmu A Digital Media Primer for Geeks że wysokie częstotliwości próbkowania dają większą przestrzeń pomiędzy najwyższą częstotliwością dźwięku na której nam zależy (20 kHz) i częstotliwości Nyquista (połowa częstotliwości próbkowania). To pozwala na użycie łagodniejszych filtrów antyaliasingowych, a tym samym wyższą wierność. Ta dodatkowa przestrzeń pomiędzy 20kHz i częstotliwością Nyquista jest w zasadzie tylko widmowym wypełniaczem dla filtra analogowego.

Powyżej: Schemat z filmu „Digital Media Primer dla maniaków” ilustrujących szerokość pasma przejścia dostępnego dla 48 kHz ADC/DAC (z lewej) i 96kHz ADC/DAC (z prawej).

Ale to nie wszystko. Ponieważ filtry cyfrowe mają tylko niektóre z ograniczeń filtrów analogowych, możemy zakończyć proces antyaliasingu z większą wydajnością i precyzją w domenie cyfrowej. Bardzo wysoka częstotliwość surowego sygnału cyfrowego przechodzi przez antyaliasingowy filtr cyfrowy, który już nie ma problemu żeby się wpasować w ciasne pasmo przejścia. Po cyfrowym antyaliasingu, nadmiarowe próbki wypełniające są po prostu odrzucane. Odtwarzanie nadpróbkowanego sygnału działa analogicznie w odwrotnym kierunku.

Oznacza to, że możemy korzystać z niskiego próbkowania 48 kHz lub 44,1 i mieć dźwięk ze wszystkimi korzyściami jakości 192 kHz lub wyższego próbkowania (wyrównana charakterystyka przenoszenia, niski aliasing) i żadnych wad, które wysoki sampling powoduje (ultradźwięki, zniekształcenia intermodulacyjne, zmarnowana przestrzeń nośnika). Prawie wszystkie dzisiejsze przetworniki analogowo-cyfrowe (ADC) i cyfrowo-analogowe (DAC) działają na oversamplingu z wysokimi częstotliwościami. Niewielu ludzi zdaje sobie sprawę że to ma miejsce, bo odbywa się to całkowicie automatyczna i dyskretnie.

ADC i DAC nie zawsze faktycznie oversamplują. Trzydzieści lat temu, niektóre konsole rejestrowały na wysokich częstotliwościach próbkowania i miały jedynie filtry analogowe, a produkcja i mastering po prostu używał tych wysokich częstotliwości. Cyfrowy antyaliasing i decymacja (resampling do niższej częstotliwości na płytach CD lub DAT) odbywały się w końcowej fazie masteringu. To może być jeden z powodów, że 96kHz i 192kHz od początku kojarzył się wszystkim z profesjonalną produkcją muzyczną[8].

16 bit vs. 24 bit

Ok. Więc muzyka w plikach 192 kHz nie ma sensu. Trafiony, zatopiony. Ale co z porównaniem audio w 16 bitach z 24 bitowym?

To prawda, że audio LPCM 16 bitów nie pokrywa całego zakresu słyszenia przez słuch człowieka w idealnych warunkach. A więc są (i zawsze będą) powody, żeby użyć więcej niż 16 bitów w nagrywaniu i w produkcji.

To jednak nie ma znaczenia dla odtwarzania; tu 24 bity są tak samo bezużyteczne jak sampling 192kHz. To po prostu nic nie daje, tylko pliki są większe.

Wróćmy do uszu

Omówiliśmy zakres częstotliwości ucha, ale co z zakresem dynamiki od najcichszych dźwięków do najgłośniejszych możliwych?

Jednym ze sposobów, aby zdefiniować pełny zakres dynamiczny będzie ponowne spojrzenie na wykres absolutnego progu słuchu i krzywych bólu. Odległość między najwyższym punktem na progu krzywej bólu i najniższym punktem na krzywej progu absolutnego słuchu wynosi około 140 decybeli dla młodego, zdrowego słuchacza. Jednak to nie potrwa wiecznie; + 130dB jest wystarczająco głośne, aby trwale uszkodzić słuch w kilka sekund lub minut. Dla porównania młot pneumatyczny w odległości jeden metr to tylko 100-110dB.

Bezwzględny próg podnosi się wraz z wiekiem i utratą słuchu. Co ciekawe, próg bólu obniża się z wiekiem, a nie wzrasta. Komórki słuchowe w ślimaku jako takie posiadają tylko część zakresu 140dB; mięśnie w uchu ciągle regulują ilość dźwięku docierającego do ślimaka poprzez przesunięcie kosteczek słuchowych, podobnie jak tęczówka reguluje ilość światła wpadającego do oka[9]. Mechanizm ten sztywnieje wraz z wiekiem, co ogranicza zakres dynamiki ucha i zmniejsza skuteczność jego mechanizmów obrony[10].

Hałas otoczenia

Niewiele osób zdaje sobie sprawę jak naprawdę cichy jest bezwzględny próg słuchu.

Najcichszym odczuwalnym dźwiękiem jest -8dB SPL[11]. Przy użyciu skali A-ważonej, szum 100 watowej żarówki mierzony z jednego metra jest o 10dB SPL a więc o 18 dB głośniejszy. Żarówka będzie dużo głośniejsza jeśli jest podłączona do ściemniacza.

20 dB SPL (lub 28 dB głośniejszy niż najcichsze dźwięki słyszalne) jest często cytowane jako cisza w pustym studio nagraniowym/nadawczym lub w komorze bezechowej. To jest wyjątkowo ciche otoczenie i jeden z powodów, dlaczego prawdopodobnie nigdy nie słyszałeś włączonej żarówki.

Zakres dynamiczny 16 bitów

LPCM 16 bitów ma zakres dynamiki 96dB według najbardziej powszechnej definicji, która oblicza zakres dynamiki mnożąc ilość bitów razy 6dB. Wielu myśli, że 16-bitowy dźwięk nie może rejestrować dźwięków cichszych niż -96dB. Tak nie jest.

Poniżej linki z dwoma plikami audio 16-bitów; jeden zawiera sygnał 1kHz przy 0 dB (gdzie 0 dB jest najgłośniejszym możliwym tonem), a drugi to sygnał 1kHz przy -105dB.

Próbka 1: 1kHz tone at 0 dB (16 bit / 48kHz WAV) [Linki do próbek nie działają]

Próbka 2: 1kHz tone at -105 dB (16 bit / 48kHz WAV)

Powyżej: Analiza spektralna tonu o poziomie-105dB zakodowanego jako 16 bit/48kHz PCM. 16 bit PCM ma dynamikę znacznie większą niż 96dB, dźwięk -105dB jeszcze może być zapisany tak, aby go można było usłyszeć.

Jak jest możliwe zakodowanie tego sygnału bez zniekształceń i zakodowanie go znacznie powyżej poziomu szumu, gdy szczyt tego tonu ma amplitudę nieco ponad jedną trzecią bita?

Tą zagadkę wyjaśnia częściowo odpowiedni dither, który renderuje szum kwantyzacji niezależny od sygnału wejściowego. Oznacza to, że ditherowana kwantyzacja nie powoduje zniekształceń, tylko chaotyczny szum. To z kolei oznacza, że możemy zakodować sygnał o dowolnej głębokości, nawet taki o szczytowej amplitudzie znacznie mniejszej niż jeden bit[12]. Jednak nie zmienia faktu, że jeśli sygnał spadnie poniżej poziomu szumów, to powinien zaniknąć. Więc jak to jest możliwe, że ton -105dB wciąż jest wyraźnie słyszalnym sygnałem na tle szumu -96dB?

Odpowiedź: Nasze wyobrażenie szumu -96dB jest zasadniczo błędne; stosujemy niewłaściwe określenie zakresu dynamicznego. 6 bitów pomnożone przez ilość dB daje RMS szumu całego sygnału szerokopasmowego, ale każda frakcja włosków ucha jest czuła tylko na wąski fragment całkowitej szerokości pasma. Jeśli każda komórka słuchowa odbiera jedynie ułamek całkowitej energii poziomu szumu to poziom szumu w tej komórce będzie znacznie niższy niż wartość szerokopasmowej całości -96dB.

Tak więc, 16-bitowe audio może zejść znacznie głębiej niż 96dB. Dzięki zastosowaniu ukształtowanego ditheru, który umiejscawia szum kwantyzacji w zakresie częstotliwości, gdzie trudniej jest go usłyszeć, skuteczny zakres dynamiczny 16 bitowego audio osiąga w praktyce 120dB[13], więcej niż piętnaście razy niżej niż roszczenie 96dB.

120dB jest większą różnicą niż między komarem w odległości paru metrów i młotem pneumatyczny w odległości 30 cm w tym samym pokoju ... lub różnicą pomiędzy pokojem dźwiękoszczelnym i dźwiękiem na tyle głośnym, aby spowodować uszkodzenia słuchu w ciągu kilku sekund.

16 bitów jest wystarczające do zapisania wszystkiego co jesteśmy w stanie usłyszeć i będzie zawsze wystarczać.

Stosunek sygnału do szumu

Warto wspomnieć wspomnieć, że stosunek S/N (sygnał/szum) ucha jest mniejszy niż jego całkowity zakres dynamiczny. W ramach wybranego wąskiego pasma typowe S/N szacuje się na zaledwie 30 dB. Względna S/N nie osiągnie pełnego zakresu dynamicznego nawet biorąc pod uwagę szerokie zakresy pasm. 16-bitowy LPCM oferuje wobec tego większą rozdzielczość niż w rzeczywistości jest to wymagane.

Warto również wspomnieć, że zwiększenie głębi bitowej odwzorowania dźwięku od 16 do 24 bitów nie zwiększa wyczuwalnej rozdzielczości lub "finezyjności" brzmienia. To tylko zwiększa zakres dynamiki, zakres między najcichszym możliwym i najgłośniejszym dźwiękiem, poprzez obniżenie poziomu szumów. Jednak 16-bitowy poziom szumu jest już piętro poniżej tego, co można usłyszeć.

Kiedy 24-bity mają znaczenie?

Zawodowcy używają samplowania 24 bity w nagrywaniu i produkcji[14] by mieć przestrzeń, niskie szumy i wygodę.

16 bitów wystarczy żeby objąć faktyczny zakres słyszenia i to z rezerwą. Nie obejmuje całego możliwego zakresu sygnału w sprzęcie audio. Głównym powodem do wykorzystania 24 bitów podczas nagrywania jest możliwość uniknięcia błędów; zamiast się mozolić aby trafić z poziomem zapisu 16 bitów - ryzykując Clipping jeśli nagrasz za głośno lub dodanie szumów jeśli za cho - 24 bity pozwalają operatorowi ustawić poziom z większą tolerancją i nie martwić się zbytnio o resztę. Nieoptymalne ustawienie wzmocnienia przez kilka brakujących bitów nie ma już żadnych konsekwencji i skutkuje dużą rezerwą zakresu dynamiki możliwym do wykorzystania w dalszej pracy.

Inżynier wymaga także więcej niż 16 bitów w czasie miksowania i masteringu. Nowoczesne metody pracy mogą obejmować dosłownie tysiące efektów i operacji. Szum kwantyzacji i poziom szumu w 16-bitowym próbkowaniu mogą być niewykrywalne podczas odtwarzania, ale mnożąc ten szum kilka tysięcy razy w końcu stajnie się zauważalny. 24 bity utrzymują nagromadzony szum na bardzo niskim poziomie. Gdy muzyka jest gotowa do dystrybucji, nie ma już powodu, aby zachować więcej niż 16 bitów.

Testy odsłuchowe

Zrozumienie jest połączeniem teorii i praktyki. Sprawa jest rozstrzygnięta tylko wtedy, gdy obie strony się ze sobą zgadzają.

Materiały doświadczalne z odsłuchów uwierzytelniają twierdzenie, że 44,1 kHz/16 bitów zapewnia odtwarzanie najwyższej możliwej wierności. Istnieje wiele badań potwierdzających to w warunkach kontrolowanych, ale ja cytuję jedynie materiał z odsłuchu w pętli w standardzie CD A/D/A wpiętej w sprzęt odtwarzający o wysokiej rozdzielczości Audibility of a CD-Standard A/D/A Loop Inserted into High-Resolution Audio Playback przeprowadzony przez Boston Audio Society .[tłumaczenie dokumentu jest tutaj]

Niestety, pobranie dokumentu wymaga pełnego członkostwa AES. Jednak dokument był omawiany szeroko w artykułach i na forum z udziałem autorów. Oto kilka linków:

The Emperor's New Sampling Rate [Ten link już nie działa]

Hydrogen Audio forum discussion thread

Supplemental information page at the Boston Audio Society, including the equipment and sample lists

Artykuł pokazuje jak słuchacze mieli odróżnić materiał dźwiękowy DVD-A/SACD; wybrany przez zwolenników wysokiej rozdzielczości, aby pokazać jej wyższość; a tym samym materiałem resamplowanym do standardu 16-bit/44.1 kHz jak w CD. Słuchacze zostali poproszeni o identyfikację każdej różnicy między nimi za pomocą metodologii ABX. BAS przeprowadziło test z użyciem wysokiej klasy profesjonalnego sprzętu w studio odizolowanym od zewnętrznego hałasu z udziałem zaawansowanych amatorów i słuchaczy zawodowych.

W 554 próbach słuchacze wybrali poprawnie w 49,8% przypadków. Innymi słowy zgadywali. Żaden słuchacz przez cały czas badania nie był w stanie określić, co było 16/44,1 a co wysoką rozdzielczością, a 16-bitowy sygnał nawet nie był ditheringowany!

W jednym z ostatnich badań[16] sprawdzano możliwość usłyszenia ultradźwięków, jak to sugerowały wcześniejsze badania. Test został tak skonstruowany, aby zmaksymalizować możliwość ich wykrycia poprzez umieszczenie produktów intermodulacji tam, gdzie mogą być najbardziej słyszalne. Okazało się, że ultradźwięki nie były słyszalne, ale zniekształcenia intermodulacji wprowadzone przez głośniki były.

Dokument ten zainspirował wiele dalszych badań, wiele z nich zakończonych różnymi rezultatami. Niektóre dwuznaczności zostały wyjaśnione stwierdzając, że ultradźwięki mogą wywoływać więcej zniekształceń intermodulacyjnych we wzmacniaczu mocy niż oczekiwano. Na przykład, David Griesinger powielił ten eksperyment [17] i stwierdził, że jego konfiguracja głośników nie wprowadziła słyszalnych zniekształcenia intermodulacyjnych z ultradźwięków, ale zrobił to jego wzmacniacz stereofoniczny.

Jak (nieumyślnie) zepsuć porównanie odsłuchu

Najczęstszy komentarz jaki słyszałem od wierzących w bardzo wysokie próbkowanie dźwięku był następujący (parafrazując): "Słuchałem dźwięku o wysokiej rozdzielczości u siebie i poprawa była oczywista. Mówisz poważnie, że mam nie ufać własnym uszom?"

Oczywiście, że można zaufać własnym uszom. To mózgi są naiwne. Nie mam na myśli nic lekceważącego; jako ludzie, jesteśmy wszyscy podatni na zwodzenie.

Efekt nastawienia, efekt placebo i podwójnie ślepa próba

W każdym teście, gdzie testujący ma dwie opcje powiązane z innymi rzeczami nie związanymi ze słuchaniem, wyniki będą zwykle takie jak osoba zakłada z góry; nazywa się to efektem nastawienia (ang. Confirmation bias - błąd konfirmacji) i jest on podobny do efektu placebo. Oznacza to, że można "usłyszeć" różnice ze względu na podświadome bodźce i własne preferencje, które nie mają nic wspólnego z dźwiękiem, jakby ktoś wolał droższy (lub bardziej atrakcyjny) wzmacniacz od tańszego.

Ludzki mózg jest tak zbudowany, by zauważyć wzorce i różnice nawet tam, gdzie ich nie ma. Tej tendencji nie można wyeliminować po prostu prosząc kogoś, aby podejmował obiektywne decyzje; jest to całkowicie podświadome. Nie można pokonać stronniczości przez nieco sceptycyzmu. Kontrolowane eksperymenty pokazują, że świadomość błędu konfirmacji może raczej zwiększyć niż zmniejszyć ten efekt! Testy, które nie mogą całkowicie wyeliminować nastawienia badanych są bezwartościowe[18].

W badaniu pojedynczo-ślepym, słuchacz nie ma informacji o wyborach testowych i nie otrzymuje informacji zwrotnej w czasie trwania testu. Badanie w pojedynczym ślepym teście jest lepsze niż zwykłe porównywanie, ale nie eliminuje stronniczości eksperymentatora. Administrator testu może łatwo przypadkowo wpływać na test lub przesyłać własne podświadome nastawienie do słuchacza przez podprogowe sygnały (np. "Czy jesteś pewien, że to słyszysz?", język ciała wskazujący na "zły" wybór, wahając się przypadkowo, etc ). Zostało również eksperymentalnie udowodnione, że nastawienie eksperymentatora ma wpływ na wyniki testu.

Badania odsłuchowe podwójnie ślepego testu są przyjętym standardem; w tych testach ani testujący ani testowany nie posiada wiedzy o zawartości wyników badań w bieżących próbach. Testy ABX prowadzone z udziałem komputera są najbardziej znanym przykładem i są dostępne jako narzędzia do wykonywania testów ABX na własnym komputerze[19]. ABX jest uważany za konieczne minimum do testu odsłuchowego; szanujące się fora internetowe audio jak np. Hydrogen Audio

często nie pozwalają na omówienie wyników słuchania, jeżeli nie spełni się tego minimalnego wymogu obiektywizmu [20].

Powyżej: Narzędzie ABX.

Ja osobiście nie robię żadnych badań porównawczych jakości podczas pracy, bez względu na to jak sprawa może być banalna, bez narzędzia ABX. Nauka jest nauką, nie partactwem.

Sztuczki z głośnością

Ludzkie ucho może świadomie wyłapać różnice amplitudy 1 dB, a eksperymenty pokazują, że podświadomie słyszy się różnice amplitudy poniżej 0,2dB. Ludzie niemal powszechnie uważają głośniejszy dźwięk za brzmiący lepiej, a 0,2dB wystarczy do potwierdzenia tej preferencji. Wszelkie porównania, które niedokładnie wyrównują poziom będą skutkować wyborem głośniejszego za lepsze nawet jeśli różnica amplitudy jest zbyt mała, aby ją wychwycić świadomie. Sprzedający sprzęt wiedzą o tej sztuczce od dawna.

Profesjonalne testy dopasowują głośność źródeł w granicach 0,1dB lub lepiej. To często wymaga użycia oscyloskopu lub analizatora sygnału. Zgadywanie czy głośność jest jednakowa przez obrót pokręteł w dwóch źródłach dźwięku nie wystarcza.

Clipping

Clipping to następny oczywisty błąd, czasem widoczny dopiero z perspektywy czasu. Nawet kilka uciętych próbek lub ich następstwa są łatwo słyszalne w porównaniu do czystego sygnału.

Niebezpieczeństwo clippingu jest szczególnie szkodliwe w testach, które tworzą, resamplują lub w inny sposób manipulują na bieżąco sygnały cyfrowe. Załóżmy, że chcemy porównać jakość samplingu 48kHz do oryginalnego sygnału 192kHz. Typowym sposobem jest downsamplowanie

192kHz do 48 kHz i upsamplowanie z powrotem do 192 kHz, a następnie porównanie z oryginałem 192kHz w teście ABX[21]. Takie rozwiązanie pozwala na wyeliminowanie możliwości wpłynięcia na rezultat przez sprzęt lub zamienienie próbek; możemy korzystać z tego samego DAC do odtworzenia obu plików i przełączać się między próbkami bez zmiany sprzętu.

Niestety, większość nagrań jest masterowana, aby korzystać z pełnej skali dynamiki. Naiwny resampling może i często będzie powodował sporadyczny clipping. Konieczne jest albo sprawdzenie czy występuje clipping (i odrzucenie plików z obcięciami) lub uniknięcie clippingu przez inne środki, takie jak ściszenie.

Inny nośnik, inny mastering

Przejrzałem kilka artykułów i blogów, które deklarują wirtuozerię nagrań 24 bity 96/192 kHz w porównaniu CD do DVD-audio lub SACD "tego samego nagrania". Takie porównanie jest nieuprawnione, bo mastering jest zazwyczaj inny.

Rzeczy nieporównywalne

Nieporównywalne ze sobą materiały dźwiękowe zdarzają się w sposób nieunikniony w starszych analogowych i hybrydowych cyfrowo/analogowych konfiguracjach testowych. Czysto cyfrowe konfiguracje testowania mogą całkowicie wyeliminować problem niektórych form testowania, ale także pomnożyć możliwość powstawania złożonych błędów w oprogramowaniu. Takie ograniczenia i błędy mają długą historię powodując fałszywe dodatnie wyniki testów[22].

The Digital Challenge -więcej na ABX Testing, przytacza fascynującą historię konkretnego testu odsłuchowego przeprowadzonego w 1984 roku w celu obalenia audiofilskiej tezy, jakoby płyty CD były z natury gorsze od winylu. Artykuł nie zajmuje się jakoś szczególnie wynikami testu (które podejrzewam będziesz w stanie odgadnąć), ale metodą działania w realnym świecie oraz niechlujstwem mającym miejsce przy prowadzeniu takiego badania. Na przykład, błąd ze strony testerów spowodował, że zaproszony ekspert audiofil nie dokonywał wyborów w oparciu o jakość dźwięku, ale przez to, że były różniące się kliknięcia przekaźników przełącznika ABX dla wyjścia analogowego!

Anegdoty nie zastępują danych, ale ta historia jest pouczająca i ukazuje łatwość, z jaką można wypaczyć testy odsłuchowe. Niektóre z omawianych tu przekonań audiofilskich są również dość zabawne; niektóre współczesne przykłady przypuszczalnie będą uznane za tak samo głupie za następne 20 lat.

Wreszcie dobre wieści

Co faktycznie może poprawić jakość dźwięku cyfrowego, który słuchasz?

Lepsze słuchawki

Najprostsze rozwiązanie nie jest cyfrowe. Największa możliwość poprawy jakości w odniesieniu do kosztów to dobre słuchawki. Słuchawki nauszne, douszne, otwarte lub zamknięte, to nie ma nic do rzeczy. Nie muszą nawet być drogie, choć drogie słuchawki mogą być warte swojej ceny.

Należy pamiętać, że niektóre słuchawki są drogie, ponieważ są one dobrze wykonane, trwałe i brzmią świetnie. Inne są drogie, bo przetworniki za 20 dolarów są schowane pod kilkoma warstwami stylizacji, marki i marketingu za sto dolarów. Nie będę tu dawać rekomendacji konkretnych słuchawek, ale powiem, że raczej nie jest możliwe, aby znaleźć dobre słuchawki w dużym markecie, nawet jeśli specjalizuje się on w elektronice i muzyce. Jak we wszystkich innych aspektach konsumenckiego hi-fi trzeba szukać i przeciwstawić się sprzedawcom.

Formaty bezstratne

To prawda, że prawidłowo zakodowany plik Ogg (lub MP3 lub plik AAC) w umiarkowanym bitrate będzie nie do odróżnienia od oryginału.

Ale co ze źle zakodowanymi plikami?

Dwadzieścia lat temu, wszystkie enkodery mp3 były naprawdę złe jak na dzisiejsze standardy. Wiele z tych starych, złych enkoderów jest nadal w użyciu, prawdopodobnie dlatego, że licencje są tańsze, a większość ludzi nie słyszy różnicy lub nie dba o to. Jaka firma będzie wydawać pieniądze, aby naprawić coś o czym nikt nie wie, że jest kiepskie?

Sięgnięcie po nowsze formaty jak Vorbis lub AAC nie musi pomóc. Na przykład wiele firm i osób prywatnych używało (i nadal korzysta) z bardzo niskiej jakości FFmpega wbudowanego w enkoder Vorbis, ponieważ był domyślny w FFmpeg i nikt nie miał świadomości jak był kiepski. AAC ma jeszcze dłuższą historię szeroko rozpowszechnionych niskiej jakości przetworników; każdy mainstreamowy format stratny ma.

Formaty bezstratne, jak FLAC pozwalają uniknąć możliwości obniżenia jakości dźwięku[23] przez słabej jakości stratny enkoder, a nawet dobry enkoder stratny użyty nieprawidłowo.

Drugim powodem by stosować bezstratne formaty dystrybucji jest uniknięcie straty generacyjnej. Każde przekodowywanie lub transkodowanie traci coraz więcej danych; nawet jeśli pierwsze kodowanie jest przejrzyste, to bardzo możliwe, że drugie będzie miało słyszalne artefakty. Ma to znaczenie dla wszystkich, którzy chcą remiksować lub samplować swoje pliki. To szczególnie ważne dla nas, pracujących z samplami, bo potrzebujemy mieć do pracy czysty materiał.

Lepszy mastering

Test BAS wspomniany wcześniej dodaje na marginesie, że wersje SACD nagrania brzmią znacznie lepiej niż w wydaniu CD. Nie z powodu zwiększonej częstotliwości próbkowania i głębokości bitowej, ale dlatego, że SACD ma mastering wyższej jakości. Przerzucona na płytę CD-R, wersja SACD wciąż brzmi tak dobrze jak oryginalne SACD i lepiej niż wydanie CD, ponieważ oryginalne audio użyte do wydania na SACD było lepsze. Dobra produkcja i mastering oczywiście przyczynia się do ostatecznego podniesienia jakości muzyki[24].

Nowe wersje "Mastering dla iTunes" i podobne inicjatywy z innych wytwórni są dość zachęcające. Okaże się czy Apple i inni rzeczywiście zrobią to jak trzeba czy też jest to tylko haczyk do sprzedaży konsumentom droższych kopii muzyki, którą już mają.

Surround

Innym haczykiem na klienta są nagrania dźwięku przestrzennego. Niestety jest tu pewne niebezpieczeństwo techniczne.

Stary styl dyskretnego dźwięku przestrzennego z wieloma kanałami (5.1, 7.1, itd) jest reliktem technicznym stosowanym w kinach do 1960 roku. Stosowanie większej liczby kanałów niż w przypadku konkurencyjnych systemów jest nieefektywne. Obraz przestrzenny jest ograniczony, i ma tendencję do przemieszczania się w kierunku bliższych głośników, gdy słuchacz przesuwa się z optymalnej pozycji.

Możemy reprezentować i kodować doskonałą lokalizację z systemami jak Ambisonics. Problemem są koszty sprzętu do reprodukcji i fakt, że coś zakodowane w naturalnej akustyce brzmi źle, gdy się to odtwarza się w radio i takie nagrania nie mogą być tworzone sztucznie w studio w przekonujący sposób. Trudno sfałszować ambisonics lub holograficzny dźwięk, tak jak trudno sfałszować film 3D, to zawsze przeradza się w krzykliwą sztuczkę, która sprawia, że 5% ludności od tego się pochoruje.

Binaural audio jest podobne. Nie można go zasymulować, ponieważ działa nieco inaczej na każdego człowieka. Jest to wyuczona umiejętność samodzielnego dostrojenia system pinnae, kanału słuchowego oraz przetwarzania neuralnego i nigdy nie przebiega w ten sam sposób u dwóch różnych osób. Ludzie również podświadomie pochylają głowę w celu dokładniejszej lokalizacji i nie można zlokalizować dobrze źródła dźwięku dopóki tego nie zrobią. To jest coś, co nie może być ujęte w nagraniu binauralnym, choć może z dobrym skutkiem w zwykłym surround.

Są to prawie niemożliwe do obejścia przeszkody techniczne. Discrete Surround zakorzenił się na rynku, a ja osobiście szczególnie lubię możliwości oferowane przez Ambisonics.

Outro

"Nigdy nie dbałem zbytnio o muzykę.

To jest high fidelity!"

-Flanders & Swann, Song of Reproduction

Chodzi o to, by cieszyć się muzyką, prawda? Nowoczesne systemy audio są nierównanie lepsze niż już doskonałe systemy analogowe dostępne dekadę temu. Teraz to już raczej logiczna ekstrema niż jakiś istotny problem dla świata. Być może, ale złe nagrania i złe kodowanie przeszkadza mi; odciąga mnie od muzyki i pewnie nie tylko mnie.

Dlaczego więc jestem przeciwko 24/192? Ponieważ jest to rozwiązanie problemu, który nie istnieje, to jedynie nieciekawy biznes bazujący na niewiedzy i oszukiwanie ludzi. Im więcej pseudonauki idzie w świat, tym trudniej jest prawdzie przezwyciężyć "prawdziwiejszość"*) ... nawet jeśli nie jest to nic ważnego i stosunkowo ma niewielkie znaczenie. *) w oryginale: truthiness

"O wiele lepiej widzieć Wszechświat takim jakim jest, niż trwać w iluzji, nawet jeśli ona satysfakcjonuje i uspokaja."

-Carl Sagan

Dalsza lektura

Czytelnicy informują mnie o kilku znakomitych pracach, których nie znałem przed rozpoczęciem pisania mojego własnego artykułu. Teksty podzielają moje zdanie w wielu punktach i podchodzą do zagadnienia bardziej szczegółowo.

Coding High Quality Digital Audio Bob Stuart z Meridian Audio; tekst jest bardzo zwięzły mimo jego objętości. Nasze wnioski różnią się nieco (uznaje potrzebę nieco szerszego zakresu częstotliwości i większej bitowej głębi nie podając żadnego uzasadnienia), ale wywód jest jasny i łatwy do zrozumienia. [Edit: Nie mogę zgodzić się z wieloma innymi artykułami pana Stuarta, ale ten mi się bardzo podoba.]

Sampling Theory For Digital Audio [Aktualizacja linku 04.10.2012] Dana Lavry z Lavry Engineering to kolejny artykuł, który zauważyło kilku czytelników. Rozszerza mój tekst o próbkowaniu, oversamplingu i filtrowaniu z jakichś dwóch stron na bardziej szczegółowe 27 stron . Ale nie martw się, jest tam wiele ilustracji i wykresów.

Stephane Pigeon z audiocheck.net napisał by podpiąć testy odsłuchowe wykonywane w przeglądarce zawarte na jego stronie internetowej. Zestaw testów jest stosunkowo niewielki, jak na razie, ale kilka było istotnych w kontekście tego artykułu. Spisali się dobrze i uważam, że jakość jest dość dobra.

Przypisy

1. Ktoś sfrustrowany napisał:

"[Teoria Samplingu] nie została wynaleziona, żeby wyjaśnić jak działa cyfrowe audio tylko na odwrót. Digital Audio powstało na podstawie teorii, więc jeśli nie wierzysz w teorię, to nie możesz wierzyć w audio!!"

http://www.head-fi.org/t/415361/24bit-vs-16bit-the-myth-exploded

2. Jeśli to nie był najnudniejszy żart na prywatce, to niewiele brakowało.

3. Raczej mówi się o długości fal światła widzialnego mierzonego w nanometrach lub angstremach. Używam częstotliwości by to skorelować z dźwiękiem. To jest równoważne, a częstotliwość jest po prostu odwrotnością długości fali.

4. Eksperyment LED nie działa z diodami "UV", głównie dlatego, że nie są one naprawdę ultrafioletowe. Są na tyle głęboko fioletowe by spowodować trochę fluorescencji, ale świecą również w zakresie widzialnym. Prawdziwe diody ultrafioletowe kosztują od 100 do 1000 dolarów dolarów za sztukę i spowodują uszkodzenie oczu, jeżeli się je weźmie do tego testu. Diody klasy konsumenckiej tak-naprawdę-nie-UV emitują również nieco słabego światła białego aby ogólnie świeciły jaśniej więc będziesz w stanie je zobaczyć, nawet jeśli szczyt emisji był w ultrafiolecie.

5. Oryginalna wersja tego artykułu opisuje, że diody podświetlające działają w zakresie od 300-325THz (około 920-980nm) czyli przy długościach fal, które są niewidoczne. Sporo czytelników napisało, że może rzeczywiście zobaczyć światło diody w niektórych (lub wszystkich) swoich pilotach. Kilku było na tyle uprzejmych, aby dać mi znać jakie to były piloty, i byłem w stanie przetestować kilka na spektrometrze. I oto te piloty pracowały przy użyciu diod LED o wyższej częstotliwości z zakresu 350-380THz (800-850nm), po prostu nakładającym się na skrajną krawędź w zakresie widzialnym.

6. Wiele systemów nie jest w stanie odtworzyć próbkowania 96 kHz i po cichu przekonwertuje je do 48 kHz raczej niż odmawia współpracy. W takim razie ton nie będzie w ogóle odtworzony i będzie cisza bez względu na to jak nieliniowy może być system.

7. Oversampling nie jest jedyną aplikacją dla wysokich częstotliwości samplowania w przetwarzaniu sygnałów. Istnieje kilka teoretycznych zalet ograniczonego pasma dźwięku w wysokiej częstotliwości próbkowania unikając decymacji, nawet jeśli się zmniejsza częstotliwość próbkowania do dystrybucji. Nie jest jasne czy się to stosuje w praktyce, bo sposoby działania większości profesjonalnych konsol są tajemnicą handlową.

8. Czy to ma historyczne uzasadnienie czy też nie, nie ma wątpliwości, że wielu specjalistów obecnie używa wysokich częstotliwości próbkowania ponieważ błędnie zakładają, że zachowując częstotliwości ponad 20kHz dźwięk brzmi lepiej, tak jak mniemają ich konsumenci.

9. Uczucie 'uncringing' bębenków po wyłączeniu głośnej muzyki jest całkiem realne!

10. Niektóre ładne schematy można znaleźć na stronie HyperPhysics:

http://hyperphysics.phy-astr.gsu.edu/hbase/sound/protect.html#c1

11. 20µPa jest powszechnie definiowany jako 0dB do celów pomiarowych; to jest wartość w przybliżeniu równa wartości progowej słuchu przy 1 kHz. Ucho jest jednak o 8dB bardziej wrażliwe w zakresie od 2 do 4 kHz.

12. Najlepsze wyjaśnienie ditheringu, z którym miałem do czynienia: Optimal Dither and Noise Shaping in Image Processing Mimo, że to chodzi o obraz, pierwsza połowa obejmuje teorię i praktykę audio i dopiero potem wyjaśnia jego stosowanie dla obrazu.

13. Inżynier DSP może wykazać, jak to zrobił jeden z moich rodaków, że 16-bitowy dźwięk ma teoretycznie nieskończony zakres dynamiki dla czystego tonu, jeśli możesz korzystać z nieskończonej transformacji Fouriera w jego ekstrakcji; bardzo ważna koncepcja dla radioastronomii.

Chociaż słuch nie działa zupełnie jak transformacja Fouriera, to jego rozdzielczość jest stosunkowo ograniczona. Stawia to praktyczny limit na 16 bitów dla sygnałów audio.

14. Studia nagraniowe coraz częściej wykorzystują 32-bity float dlatego, że jest to najdogodniejsze na nowoczesnych procesorach oraz całkowicie eliminuje możliwość clippingu, który przeoczony mógłby zrujnować nagranie.

15. Kilka osób chciało wiedzieć dlaczego testy Meyera i Morana z 2007r. mogły dać wynik zerowy jeśli ultradźwięki mogą powodować słyszalne zniekształcenia intermodulacyjne.

Powinno być oczywiste, że "może" lub "niekiedy" to nie to samo co "musi" i "zawsze". Zniekształcenia intermodulacyjne z ultradźwięków są możliwe, że wystąpią a nie - pewne, że wystąpią w danym systemie dla danego zbioru materiału. Zerowy wynik Meyera i Morana wskazuje na to, że zniekształcenia intermodulacyjne były niesłyszalne w systemach stosowanych w trakcie ich badań.

Czytelnicy są zaproszeni do wypróbowania prostego testu zniekształceń intermodulacji powodowanych przez ultradźwięki dla szybkiego sprawdzenia potencjału własnego sprzętu.

16. Karou i Shogo, „Detection of Threshold for tones above 22kHz” (2001). Dokument z konwencji 5401 zaprezentowany na 110. Konwencji w Amsterdamie 12-15 maja 2001.

17. Griesinger, Perception of mid-frequency and high-frequency intermodulation distortion in loudspeakers, and its relationship to high definition audio

18. Od publikacji, kilku komentatorów napisało do mnie podobną wersję tej samej anegdoty (parafrazując):"Kiedyś słuchałem niektórych wzmacniaczy / słuchawek / nagrań spodziewając się wyniku [A], ale byłem całkowicie zaskoczony, bo okazało się [B] więc błąd konfirmacji jest bzdurą!"

Oferuję dwa wyjaśnienia.

Po pierwsze, błąd konfirmacji nie zastępuje poprawnych rezultatów błędnymi. Zniekształca tylko wyniki w jakimś niekontrolowanym kierunku i w nieznanym stopniu. Jak można coś określić jako pewne, jeśli test jest reżyserowany przez własną podświadomość? Powiedzmy, że spodziewałem się usłyszeć dużą różnicę, ale byłem zszokowani słysząc małą. A jeśli nie było wcale żadnej różnicy? A może była różnica, a zdając sobie sprawę z potencjalnego błędu twoje dobre intencje rekompensowały sceptycyzm? A może miałeś zupełną rację? Obiektywne testy takie jak ABX, eliminują wszystkie te wątpliwości.

Po drugie, "jeśli myślisz, że nie jesteś stronniczy udowodnij to!" Wartość obiektywnego testu nie leży tylko w jego zdolności potwierdzenia własnych założeń, ale w przekonaniu innych. Twierdzenie wymaga dowodu. Nadzwyczajne twierdzenie wymaga niezwykłego dowodu.

19. Najlepsze, prawdopodobnie, narzędzia do testów ABX:

Foobar2000 ABX plug-in

20. W Hydrogen Audio, wymaganej do testów jest skrócone TOS8 - ósma pozycja w warunkach korzystania z usługi.

21. Powszechnie przyjmuje się, że resampling nieodwracalnie uszkadza sygnał; to nie jest prawda. Jeśli ktoś nie robi oczywistych błędów, takich jak powodowanie clippingu, to sygnał po upsamplingu i resamplingu będzie nie do odróżnienia od oryginału. Tak się zazwyczaj robi by wykazać, że wyższe częstotliwości samplowania są zbędne.

22. To może nie być ściśle związane z audio, ale ... szybsze od światła neutrina, komentarze?

23. Magazyn Wired twierdzi, że bezstratne formaty takie jak FLAC nie zawsze są całkowicie bezstratne:

"Niektórzy puryści namawiają, aby pomijać FLAC w ogóle i po prostu kupić WAV. [...] Kupując WAV, można uniknąć utraty danych spowodowane, kompresją pliku do formatu FLAC. Utrata danych jest rzadka, ale zdarza się". To jest fałsz. Proces bezstratnej kompresji nie zmienia oryginalnych danych w żaden sposób, a FLAC nie jest wyjątkiem.

W przypadku, który Wired miał na myśli miało miejsce uszkodzenia sprzętu i plików danych (awaria dysku, awaria pamięci); FLAC i WAV również będą uszkodzone. Plik FLAC sprawdza sumy kontrolne i wykryje uszkodzenie. Plik FLAC jest również mniejszy niż WAV i prawdopodobieństwo uszkodzenia byłoby mniejsze, bo jest mniej danych, które mogą zostać naruszone.

24. 'Loudness War' jest powszechnie cytowanym przykładem złych praktyk masteringu obecnie w branży, choć nie jest przykładem jedynym. Jest to starsze zjawisko niż to sugeruje artykuł w Wikipedii; już od 1950 roku artyści i producenci dążyli do najgłośniejszych możliwych nagrań. Dostawcy sprzętu badali fenomen i coraz częściej wprowadzali do obrotu nowe technologie, aby umożliwić bardziej głośne masterowanie. Zaawansowane urządzenia do masterowania winylu w latach 1970 i 1980, na przykład śledziły i zagnieżdżały kształty rowków gdy to było możliwe, w celu osiągnięcia wyższej amplitudy niż odstęp rowka normalnie by na to pozwolił.

Dzisiejsza technologia cyfrowa pozwala na to, że głośność jest pompowana do absurdalnego poziomu. Dostarcza również mnóstwo automatycznych, bardzo skomplikowanych, zastrzeżonych wtyczek DAW, które są wdrażane masowo bez pełnego zrozumienia jak one działają i co naprawdę robią.

01 03 2012 —Monty