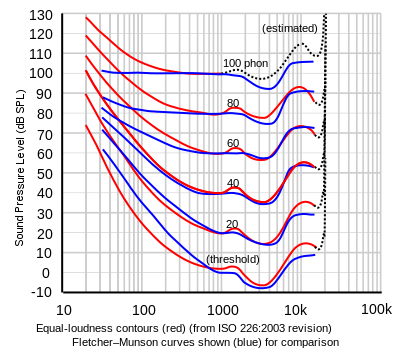

Jak można dojść do tak absurdalnego wniosku, że jitter 20 pikosekund jest słyszalny? W ten sposób, że nakładając poziom zakłóceń na krzywą Fletchera-Munsella trafia on dokładnie na sam dół krzywej poziomu słyszalności. Czyli zakłócenie ma poziom prawie -10 dB. Warto pamiętać, że 0 dB SPL nie znaczy, że zmiany w ciśnieniu wynoszą zero, więc stąd biorą się ujemne db. Faktycznie taki poziom dźwięku można usłyszeć w komorze bezechowej, gdzie panuje absolutna cisza. Pytanie jest jednak następujące: poziom zakłóceń to około -10 dB, a co z sygnałem?

Zniekształcenia nie istnieją w oderwaniu od przetwarzanego sygnału. Jeśli są zniekształcenia, to jest też sygnał, który został zniekształcony. Dlatego takie teoretyzowanie, że jeśli człowiek - chyba bardzo młody i zdrowy, dodajmy - słyszy poniżej zera dB, tzn. słyszy ujemne decybele, to nie znaczy, że usłyszy taki poziom zakłóceń. Nie usłyszy, bo fundamentalna będzie stokilkadziesiąt dB głośniejsza.

Żeby rzecz była jasna. Ktoś umyślił sobie, że skoro zakłócenia są na poziomie jeszcze słyszalnym, to po usunięciu sygnału je się da usłyszeć. Ale problem w tym, że musi grać muzyka, żeby były zakłócenia. Nie ma opcji wyciszenia muzyki, czyli zlikwidowanie sygnału, po to, żeby słuchać samych zakłóceń.

Można usłyszeć odgłos przeskakującej iskry w świecy zapłonowej, ale na to trzeba ją wykręcić z silnika. Natomiast nie da się tego usłyszeć, jak silnik pracuje.

To jest właśnie problem teoretyków. Tak jak nie ma sensu mówić o odgłosach świecy bez pracy silnika, tak nie ma sensu mówić o zakłóceniach bez sygnału czy muzyki.

W dobrej jakości przetworniku jitter rzędu 200 ps jest bardzo dobrą wartością i z całą pewnością jest niemożliwy do usłyszenia.